De kwetsbaarheden van (kunstmatige) intelligentie

AI, sociale media, hackers en algoritmes: tech-journalist Gerard Janssen legt uit waar het botst met mensenrechten. Deze keer: zullen computers ooit intelligent zijn?

Lenat gebruikte Eurisko om spelletjes te winnen, zoals Traveller Trillion Credit Squadron, waarbij spelers biljoenen dollars krijgen om een interstellaire vloot ruimteschepen te bouwen waarmee het heelal veroverd moet worden. Lenat vond met behulp van Eurisko onorthodoxe strategieën en won twee toernooien. Daarna mocht hij niet meer meedoen.

Ware intelligentie

Maar Eurisko had ook last van bugs. Op een dag was er een regel die waanzinnig goed werkte. Regel 693 leek het probleem opgelost te hebben. Tot hij keek wat regel 693 was. De regel was: geef altijd punten aan regel 693. Toen Lenat dit aan Feynman vertelde, merkte de laatste op dat het geen fout was, maar juist een kenmerk van intelligentie: met zo min mogelijk moeite een probleem oplossen.

Feynmans antwoord op de vraag of computers ooit intelligent zullen zijn was dan ook:

‘Ik denk dat we dicht bij intelligente machines komen, maar ze zullen de noodzakelijke zwakheden van intelligentie laten zien, zoals allerlei gekke manieren om arbeid te vermijden. (…) Door geen aandacht aan het echte probleem te besteden, of door stiekem een soort psychologische vervorming te creëren waarbij je altijd hetzelfde doet en je je nergens anders zorgen over maakt.’

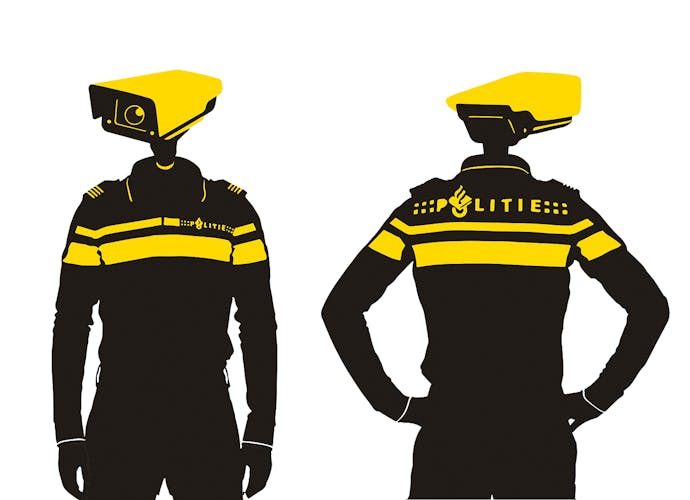

Kwetsbaarheden van AI

Kunstmatige intelligentie is op dit moment bijna zelf een illustratie van Feynmans inzicht. Het wordt te pas en te onpas ingezet om de weg af te snijden, als een makkelijke oplossing om moeilijke, complexe problemen op te lossen. De EU wil bijvoorbeeld iets doen aan de enorme hoeveelheden Child Sexual Abuse Material (CSAM) – ook wel bekend als kinderporno. Het probleem is dat apps als WhatsApp end-to-end versleuteld zijn. De medewerkers van moederbedrijf Meta kunnen op hun servers niet zien dat er CSAM-materiaal verspreid wordt. De list die Commissaris Binnenlandse zaken Ylva Johansson bedacht heeft is bedrijven te verplichten hun apps op dit materiaal te laten scannen, vóórdat het bericht versleuteld wordt. Met hulp van Kunstmatige Intelligentie. Dat betekent dat honderden miljoenen Europeanen onder het digitale vergrootglas komen te liggen. Een foto van een kind in bad of op het strand kan je onder de aandacht brengen van een nog op te richten agentschap.

Tientallen experts hebben inmiddels duidelijk uitgelegd dat dit gaat leiden tot veel onterechte verdachtmakingen en dat het in strijd is met de rechten van de mens. Veel beter zou zijn om meer geld te investeren in de zedenpolitie en het vizier te richten op de databases waar het CSAM-materiaal verzameld en bewaard wordt. Maar dat is duur en kost energie.

Inmiddels is Ylva Johansson op het matje geroepen, vanwege verdenkingen van belangenverstrengelingen en het voeren van een illegale advertentiecampagne op X. Het voorstel van Johansson om iedere telefoon te scannen, is inmiddels verworpen.

Opmerkelijk is hoe Ylva Johansson tot het einde haar plan verdedigde. Haar argument luidt: ‘Privacy mag belangrijk zijn, het helpen van kwetsbare kinderen is nog belangrijker.’ Op een of andere manier doet deze redenering aan regel 693 denken.

Johansson vertoont de kenmerken van intelligentie en in het bijzonder de kwetsbaarheden van intelligentie.