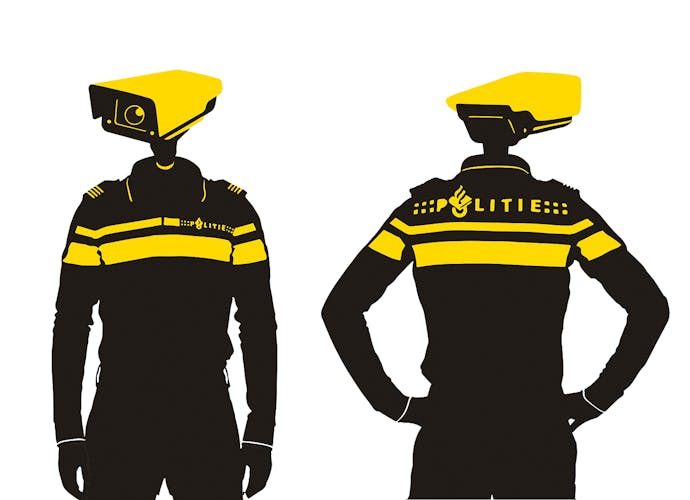

Ethisch fout, technisch mooi: toch maar doen dus

AI, sociale media, hackers en algoritmes: tech-journalist Gerard Janssen legt uit waar het botst met mensenrechten. Deze keer: wat hebben Robert Oppenheimer en de Nederlandse politie gemeen?

In augustus onthulde het journalistieke platform Follow the Money dat de Nederlandse politie levensloopdata uit politiesystemen gebruikte om te berekenen in hoeverre een persoon een risico vormde. De gebruikte data waren bijvoorbeeld het aantal keren dat iemand in aanraking was geweest met de politie of melding had gedaan van een geweldsdelict. Ook een Antilliaanse, Marokkaanse of Somalische afkomst werd gezien als risicofactor.

Een van de wonderlijkste elementen is dat de politie merkte dat het model tekortkomingen had. Uit ander onderzoek was bekend dat Antilliaanse mannen relatief vaak met geweldsmisdrijven te maken hebben, maar dat volgde niet uit dit model. Mooi zo, zou je zeggen. Maar nee. Het model werd gecorrigeerd.

Digitaal rugzakje

Als je uit de Antillen kwam, kreeg je een digitaal rugzakje en werd je automatisch even ‘gevaarlijk’ ingeschat als een witte Nederlander die vier (!) geweldsmisdrijven op zijn naam had staan. Het is allemaal te lezen in het online te vinden document Risicotaxatie Instrument Geweld (RTI-G).

Tot 2017 werden deze indicaties ook daadwerkelijk gebruikt. Je zou verwachten dat een leidinggevende bij de politie zou zeggen: dit is geen goed idee.

Maar zo werkt het niet bij technisch gereedschap. ‘Als je iets ziet dat technisch mooi is, ga je ermee door en doe je het. Je discussieert pas over wat je ermee moet doen als je technisch succes hebt gehad’, zei Robert Oppenheimer over de atoombom. Een interessant idee dat door een groep mensen wordt uitgewerkt, krijgt een eigen leven. Het is hypnotiserend.

De atoombom

In de documentaire The Day After Trinity zei Roberts broer Frank, die ook meehielp aan de bom, het zo: ‘Ongelooflijk hoe technologische hulpmiddelen iemand in de val kunnen laten lopen, ze zijn zo krachtig.’ Ook toen de nazi’s al waren verslagen, bleven alle wetenschappers doorwerken aan de atoombom. ‘Het kwam doordat de machine ons in zijn val had gelokt. We waren erop gebrand om dat ding te laten werken.’ De atoombom is niet gebouwd om Japan te overmeesteren, de bom is gemaakt omdat de wetenschappers wilden zien of het zou lukken.

Het onderzoek van Follow the Money heeft ervoor gezorgd dat de politie stopt met het model. Maar de mogelijkheden om voorspellende modellen te maken die de ‘rotte appels’ eruit halen zijn nu veel interessanter dan in 2014, zeker als je ze met een wetenschappelijke blik bekijkt. Hoewel iedere ethische of juridische expert zal zeggen dat je het niet moet doen, is de verleiding om iets te bouwen wat op een orakel lijkt te groot. De politie doet het misschien nu niet meer zelf, mede ingefluisterd door de nieuwe AI-wetten van de EU. Maar het is lastig om optimistisch te zijn over wat private bedrijven nu in het geheim allemaal uitproberen met kunstmatig intelligente algoritmes en de snelste computers.

De AI-pionier Geoffrey Hinton – die tot voor kort voor Google werkte en die nu waarschuwt voor dergelijke kunstmatige intelligentie – haalde vaak de quote van Oppenheimer aan, als hem gevraagd werd waarom hij werkte aan dit soort gevaarlijke technologie. Ook gebruikte hij een ander klassiek excuus: ‘Als ik het niet zou doen, zou iemand anders het wel doen.’