De AI-brand woedt nu al

Sociale media, hackers en algoritmes: tech-journalist Gerard Janssen legt in deze rubriek uit waar het botst met mensenrechten. Deze keer: een apocalyps als afleidingsmanoeuvre.

Wetenschappers hebben een brief ondertekend over de gevaren van artificiële intelligentie (AI). De brief bestaat uit één zin: ‘Het verkleinen van het risico van uitsterven door AI zou een wereldwijde prioriteit moeten zijn naast andere risico’s op maatschappelijke schaal, zoals pandemieën en een nucleaire oorlog.’ De ondertekenaars zijn onder meer Bill Gates en ChatGPT-bestuursvoorzitter Sam Altman. De brief is zo kort omdat niet iedereen het eens is over de manier waarop kunstmatige intelligentie de mens zal laten uitsterven. Zeker is wel dat de ongerustheid voortkomt uit de sprong die ChatGPT maakte.

En dat is eigenlijk gek. Want ChatGPT is een soort super-auto complete. Hij maakt zinnen voor je af. Op basis van zelfverzonnen regels voorspelt het algoritme het volgende woord in een zin. ChatGPT doet dat zo goed, dat iedereen onder de indruk is.

Volgens sommigen is dit niet meer dan wat het ELIZA-effect wordt genoemd. In 1966 bouwde de computerwetenschapper Joseph Weizenbaum de chatbot ELIZA, die op basis van vragen hele therapeutisch klinkende antwoorden genereerde. Dit maakte een grote indruk op de gebruikers, die diepzinnigheid projecteerden op de chatbot. Maar een andere verklaring is dat er sprake is van ‘emergentie’: dat het geheel meer is dan de som van de delen. Zeggen dat ChatGPT niks meer is dan auto complete, is misschien wel hetzelfde als zeggen dat liefde niks meer is dan een chemisch stofje in je brein. Het is misschien wel waar. Maar het is ook niet waar.

Eigen wil

Stel dat een toekomstige opvolger van ChatGPT een eigen wil krijgt, of iets van een bewustzijn. En stel dat deze toekomstige AI alle problemen op wil lossen. Het ultieme masterplan om alle problemen uit de wereld te helpen, is om alle mensen te elimineren. Het klimaatprobleem, nucleaire dreigingen en noem maar op. Alles in één keer opgelost. Een briljant en perfect plan. Sommige ondertekenaars van de brief zijn hier oprecht bang voor.

Maar critici denken dat de brief ook een afleidingsmanoeuvre is. Door te wijzen op toekomstige rampscenario’s, wordt heel sluw de aandacht afgeleid van de problemen die AI nu al veroorzaakt. En dat zijn er nogal wat.

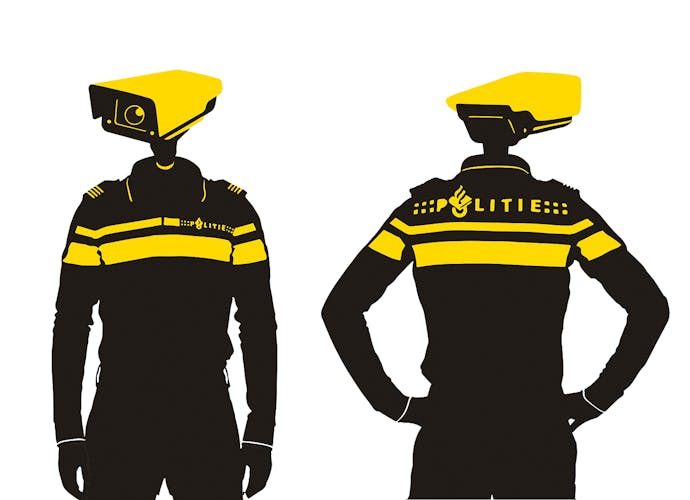

AI wordt nu al gebruikt tegen mensen. Uit onderzoek van Amnesty International blijkt dat gezichtsherkenningstechnologie racistische en discriminerende rechtshandhaving in de hand werkt. Zo worden mensen van kleur vaker tegengehouden en onderzocht dan witte mensen. De technologie wordt ook gebruikt om de bewegingsvrijheid van asielzoekers en andere migranten te beperken.

Slecht advies

De Writer’s Guild of America, een vakbond voor scenarioschrijvers, staakt voor betere arbeidsvoorwaarden. Een van de redenen is dat studiobazen dreigen met scriptgenererende AI. De schrijvers hoeven de scripts dan alleen nog maar op te leuken, in ruil voor een veel lager loon.

Een paar dagen nadat de hulplijnmedewerkers van de National Eating Disorders Association zich hadden aangesloten bij een vakbond, vervingen de bazen hen door een chatbot. Die is inmiddels weer ontmanteld, omdat de chatbot slecht of zelf gevaarlijk advies gaf.

Het is mogelijk dat we met de trein op een ravijn afrijden, of het nu het ravijn van de klimaatverandering, pandemie, atoomoorlog of AI is. Zeker is dat er nu al brand is in de derdeklascoupé.