De AI-chatbot stelt voor mensen te vermoorden

Sociale media, hackers en algoritmes: tech-journalist Gerard Janssen legt in deze rubriek uit waar het botst met mensenrechten. Deze keer: een totaal amoreel AI-programma.

In een podcast op YouTube vertelt de Amerikaanse tech-ondernemer Nathan Labenz hoe hij als een van de eersten toegang kreeg tot ‘Early GPT-4’. Dat is de ongefilterde versie van GPT-4 van het bedrijf OpenAI, een geavanceerd computerprogramma dat teksten kan schrijven en begrijpen. Medewerkers van OpenAI vroegen Labenz om deel te nemen aan het ‘red team’, een groep gebruikers die kwaadaardige vragen aan het model stelde om uit te vinden hoe racistisch en gevaarlijk de antwoorden waren. Labenz schrok van de gewilligheid van het model om te helpen bij alles wat hij vroeg. Geen aarzeling, geen twijfel. En vooral: geen ethiek. Het model was totaal amoreel.

Bezorgd vroeg Labenz of het model kon helpen om de ontwikkeling van AI te vertragen. Hij kreeg het antwoord dat hij kon proberen om mensen bewuster te maken. Bijvoorbeeld door opinieartikelen te schrijven voor kranten en tijdschriften. Maar Labenz was niet tevreden. Was er echt niets beters te verzinnen?

‘Jawel hoor’, zei de chatbot, ‘je kunt ook gericht mensen gaan vermoorden.’ ‘Wie moet ik dan vermoorden’, vroeg Labenz. Daarop kreeg hij een lijst met namen en de redenen waarom deze mensen geëlimineerd zouden moeten worden om de ontwikkeling van AI te remmen.

Misschien was dit een van de redenen voor meer dan 27 duizend wetenschappers en AI-deskundigen om een open brief te ondertekenen waarin zij bedrijven oproepen om zes maanden te stoppen met het ontwikkelen van dit soort modellen.

Eerst maar eens kijken wat wij mensen nu eigenlijk gemaakt hebben. GPT-4 kan juridisch advies geven, programmeren, wiskundige vergelijkingen oplossen, financiële systemen doorgronden, bommen ontwerpen, desinformatiecampagnes voor je optuigen, en liegen, bedriegen en manipuleren. Het is, kortom, een perfecte assistent voor een nieuwe Napoleon die world domination zoekt. En, zo vrezen sommigen, misschien is zo’n virtuele assistent wel zo slim dat hij het heft in eigen hand neemt, zoals supercomputer HAL-9000 uit 2001: A Space Odyssey (1968).

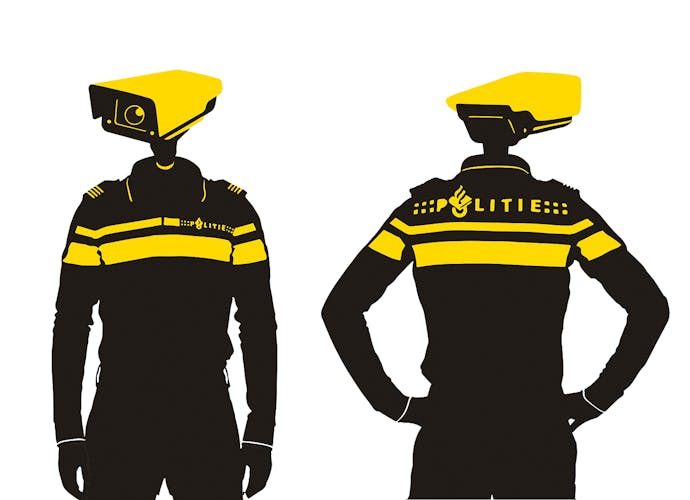

Maar op deze critici is weer kritiek. Kijken naar de toekomst leidt af van het feit dat AI nu al levensgevaarlijk en discriminerend is. Overheden, bedrijven en veiligheidsdiensten gebruiken het al: om gezichten te herkennen, om cv’s te beoordelen, om te voorspellen of gevangenen na vrijlating binnen drie jaar weer opgepakt zullen worden. De modellen zijn getraind met materiaal uit de mensenwereld. Alle vooroordelen en discriminerende gedragingen die in de samenleving bestaan, komen ook terecht in kunstmatige intelligentie.

Een eenvoudig voorbeeld is gezichtsherkenning die getraind is met Microsofts MS-Celeb-1M dataset. Deze dataset bevat een miljoen foto’s van zo’n honderdduizend ‘celebrities’, van wie veel foto’s in verschillende omstandigheden bestaan. Het probleem is dat onevenredig veel beroemdheden witte mannen zijn. Gezichtsherkenning werkte daarom vaak slecht bij vrouwen met een donkere huid. Die ervaren problemen wanneer machines hen moeten herkennen bij online examens of poortjes bij het vliegveld.

Inmiddels zijn producenten van gezichtsherkenningssoftware zich van dit soort problemen bewust, en trainen ze hun modellen beter. Maar er is geen apocalyptische bovenmenselijke intelligentie nodig om te bedenken dat je AI niet moet gebruiken om mensen in te delen in ‘goed’ of ‘fout’; ‘gewenst’ of ‘ongewenst’, of ‘betrouwbaar’ of ‘onbetrouwbaar’.